生成AI/LLMがもたらす未来のエンジニアリングスキルと働き方の変革 [CTO meetup イベントレポート]

2023年4月28日に開催されたCTOmeetupのテーマは、「生成AI/LLM」です。2023年3月にOpenAIによって公開されたGPT-4の登場以来、生成AI/LLMはビジネスシーンで広く活用され始めました。

さまざまなプロダクトに対して新たな価値を与えうる生成AI/LLMによって、近い将来、エンジニアに求められるスキルや働き方はどのような変革を迎えるのでしょうか。

今回は実際に生成AIをプロダクトに組み込み、組織つくりも始めているログラス社・Helpfeel社のCTOである坂本さんと秋山さんにお越しいただき、エンジニアに将来必要なスキルや働き方について語っていただきました。

目次

イベント概要

世間を賑わせているChatGPTをはじめとした生成AI/LLM。

あっという間にビジネスシーン活用へ広がりを見せ、その中でもエンジニアリングにおいてはさまざまな企業から日を重ねるごとにプロダクトへの組み込みに関する発信が行われています。

一方で、これだけ生成AI/LLMが浸透してくると、エンジニアに求められるスキルや仕事の進め方、働き方の変化も余儀なくされるのではないでしょうか?

そして変化の必要性は理解していながら、答えを模索している最中だと思います。

そこで今回は「生成AI/LLMがもたらす未来のエンジニアリングスキルと働き方の変革」と題して1時間半のセッションをお届け。

既に経営・プロダクトへ生成AI/LLMの取り込みを発表しているログラス社・Helpfeel社からそれぞれCTOである坂本さん秋山さんをお招きいたします。

当日はChatGPT時代とも呼ばれる、変化が必要となる将来に求められるエンジニアスキルとは何か?経営として生成AI/LLMにどう向き合っていくのかについて考えを伺います。

登壇者

坂本 龍太さん|株式会社ログラス 共同創業者取締役CTO @http204

中央大学商学部卒。東北大学会計大学院合格。

当時60人程度だったビズリーチに新卒0期生のエンジニアとして入社し主に新規事業に関わり続け、HRMOSの新規事業の開発責任者を経験。

その後、サイバーエージェントを経て、株式会社ログラスを共同創業。

秋山 博紀さん|株式会社Helpfeel CTO @akiroom

慶應義塾大学大学院政策・メディア研究科卒。11歳の頃からソフトウェア作家として活動し、2005年経済産業大臣賞を受賞。2008年未踏ソフトウェア創造事業採択。

大学院在籍中にはユーザーインタフェースおよびインタラクションデザインを研究。

現在はHelpfeel株式会社CTOとして開発チームのマネジメントや組織づくりに従事。

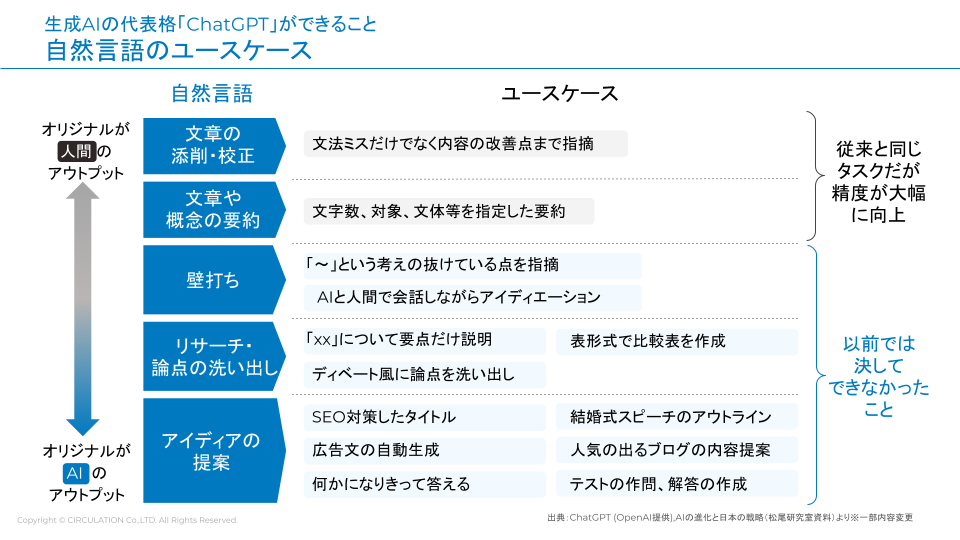

生成AIの代表格「ChatGPT」ができること

自然言語のユースケース

秋山氏:

まずは、生成AIの代表格であるChatGPTの衝撃について深掘りしてお話しできればと思います。ChatGPTは自然言語に関するシステムなので、どんなユースケースがあるのかを以下に並べています。

秋山氏:

坂本さんは、どのポイントの衝撃が大きかったですか?

坂本氏:

「これをJSONで返して」と言えば表現方法を書いてくれることとか、第一印象として非常に便利だと感じましたね。コンテンツを理解して、なおかつJSONのプロパティまで名前をつけてデータ変換してくれて、かなり驚きました。

秋山さんの第一印象はいかがでしたか?

秋山氏:

当社のプロダクトはFAQを取り扱っているので、明らかに影響を受ける分野だと思いましたね。特に応答の速さと、人間が書いているかのような自然な返しには驚きました。

最初は「面白いな」くらいの印象でしたが、公開時に発表された1000トークンあたり0.002ドルというプライシングが出た瞬間に、ChatGPT以前と以後で世界が変わると確信し、社内でも対応しました。

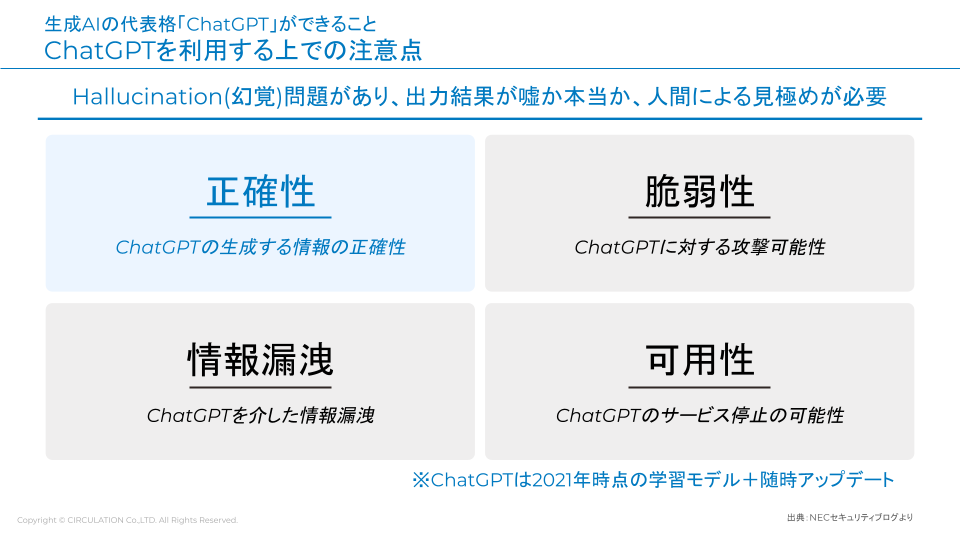

ChatGPTを利用する上での注意点

秋山氏:

一方で、ChatGPTを利用する上での注意点もありますね。正確性・脆弱性・情報漏洩・可用性といったところですが、例えば正確性に関してはHallucinationと呼ばれるAIの幻覚という問題があります。調査系に利用するのは、気を付けたほうがいいですね。信じすぎず出典にあたるのが大事です。

脆弱性については、最近プロンプトインジェクションの話題がありました。

坂本氏:

対応しきれている会社さんはまだ存在しないと思うので、対策に関する情報は追っていく価値がありますね。

秋山氏:

情報漏洩に関しては、学習されてしまうリスクがありますよね。先日も大手企業の従業員が社内の機密をChatGPTに入力したことがニュースになっていて、4月25日には学習されないようオプトアウトができるようになりました。APIはそもそも学習に使えない規約もありますから、その点組み合わせを考える必要があります。

あとは可用性の問題ですね。これは、Web APIを使う上では当然考えるべきことです。坂本さんはこれら4つのうち、どれが一番気になりますか?

坂本氏:

情報漏洩については極めて大きな課題感を持っています。弊社プロダクトにも一部生成AI / LLM技術を組み合わせており、もちろん現状はAPIなので学習はされないものの、「こういった情報は入力しないでください」と断り文を記載しています。

お客様の情報自体を本当にセキュアに使えるかどうかは、今後の大きなチャレンジになると思っています。

生成AI/LLMがもたらす働き方やスキルの変化とは?

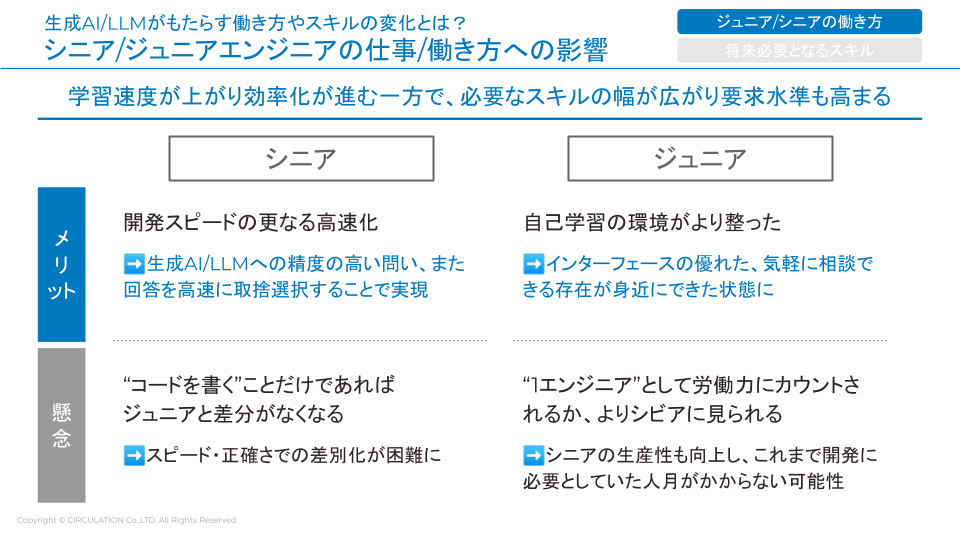

シニア/ジュニアエンジニアの仕事/働き方への影響

秋山氏:

ここからは、生成AIやLLMがもたらすエンジニアの働き方やスキルの変化についてお話ししていければと思います。大きく「ジュニア/シニアの働き方」と、「将来必要となるスキル」の2軸を話題にしていきましょう。

まず、生成AIやLLMによって学習速度が上がり、必要なスキル幅も広がる可能性がありますよね。坂本さんは、シニアエンジニアに関してはどのような変化が起きるとお考えですか?

坂本氏:

例えば当社はGitHub Copilotを使う社内エンジニアがかなり増えていまして、SQLではかなり力を借りています。言語ごとの癖のあるDSL記述まで含めて自動でできるので、開発のスタートとエンドがきちんと決まっているようなものであれば、非常に素早く開発できます。コードの自動生成もかなりの範囲でできていて、とあるシニアエンジニアはコードの5割を手書きしていないレベルです。

今後は、ほかのメンバーにもこういった動きを推進してもらい、なおかつスピードアップを称賛することが大事だと考えています。秋山さんはいかがですか?

秋山氏:

当社の場合はGitHub Copilotの活用でコードを書くのが速くなったのはもちろんですが、それ以上に日本語のコミュニケーションが楽になった面が大きいですね。例えばインフラエンジニアであれば、GCPやAWSの担当者に確認を取るときの挨拶文の素案をAIですぐに書ける。技術ブログの文章の組み立ても、ChatGPTに相談できます。

コードを書くという意味では、シニアとジュニアで差がなくなる話もありますが、このあたりはどんな印象ですか?

坂本氏:

課題設定さえ正しくできれば解決する言語も正しく出てくると思うので、コードを書けるかどうかという部分の差はなくなってくるでしょうね。

ただ、サービスやアーキテクチャ全体の広いコンテキストを理解した上でコードを書くとなった際には、シニアとジュニアで差が生まれます。シニアエンジニアとしてどこに価値を出していくのかは難しい部分がある一方、ある意味チャンスでもあるのかもしれません。

秋山氏:

ジュニア側の話も掘り下げてみたいのですが、ジュニアにとって今は嬉しい時代かもしれません。ChatGPTで自己学習をすると、Hallucinationのリスクはあるものの、ある程度精度の良い答えが返ってくるからです。

一方で、コーディングや実装部分に限ってはChatGPTに書かせたほうが、人間より速い場面が出てくるでしょう。このあたり、いかがですか?

坂本氏:

学習意欲のある方にとっては、AIがハシゴや自転車のような役割になってくれますよね。私が新卒だった頃は、ゼロから技術をキャッチアップするのは相当難しかったです。常識やスタンダードがわからないですし、教本を見てプログラミングを覚えても、いざ自社サービスのコードを書こうとしたら1,000倍複雑だからです。

何が正しいのかわからない中でも、今はゴール設定さえ決まっていれば答えを検証可能で、自己解決能力をかなりブーストできると思います。業務外で勉強をして、自分だけで知識をアップデートし続けられる環境がそろったのは、素晴らしいですよ。

ただ、みんながAI、LLMという自転車に乗っているわけなので、その中で自分がどう価値を出すのかは問われますね。

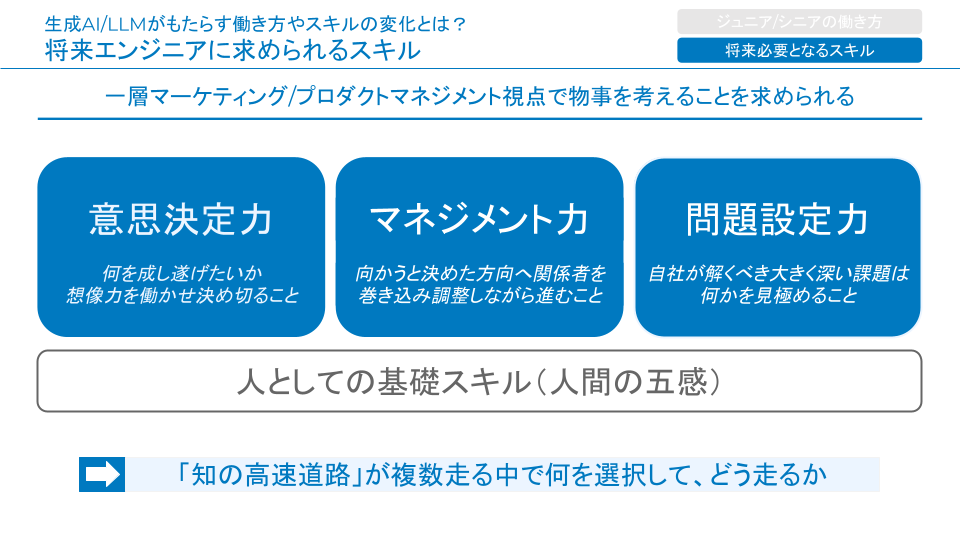

将来エンジニアに求められるスキル

秋山氏:

では次に、将来エンジニアに求められるスキルについて議論したいと思います。事前の打ち合わせでは「知の高速道路」の話題が出ました。知識にたどり着く速度が上がって、次の段階に行きやすくなるという2007年頃の考え方ですが、現代は知識へのアクセスに関して、一段階先の時代に入った感じがします。

その中で必要になるスキルセットは、意思決定力やマネジメント力、問題設定力などだと考えられます。どれも近しい内容かもしれませんが、まずは意思決定力について。今はChatGPTでちょっとした連絡もプログラミングも、やりたいと思えばスピードにブーストをかけられますが、「それをやる」と決める力は、まだ人間側に残っていますよね。

坂本氏:

そうですね。自己学習の環境が整った話も然りですが、「これをやりたい」という気持ちを持ってどんな行動に移すのか自体は、ChatGPT自体が決めてくれるわけではありません。自分が核を持ってデリバリーする力が、非常に求められます。「言い出しっぺ力」「チャレンジしてビジョンを描いていく力」なども、意思決定力の一部ですね。

秋山氏:

何か選択肢があったときに「これは面白いからやるぞ」と言い出す姿勢は、今後必要になりそうです。

坂本氏:

自分の内側から出てくるものをいかに大事にできるかは、知の高速道路にどう乗るのかという話にもつながりそうだなと。

秋山氏:

マネジメント力もテーマとして挙げました。いざやりたいことに向かうとしても、ChatGPTは全知全能の神ではないので、プロンプトで伝える必要があるじゃないですか。どう伝えてどんな順番でやっていくのか、ChatGPTに聞くという手段も含めて決める必要があります。これはマネージャーの能力に近いのかなと。

ChatGPTは部下を5人つける大変さを思うと1000件でもすぐにスケールできるので、人間と向き合うのとは違うスキルでもあるのかもしれませんが……。

坂本氏:

個人的に、やはり自分の力だけで解決できることは少ないと思うんですよね。スペシャリストの素晴らしいエンジニアも、人とつながり、巻き込みながら何かを動かしていくことになります。

たとえマネージャーにはならないとしても、自分が持っている課題感をきちんとメンバーにシェアした結果生まれるレバレッジは非常に大きいでしょう。そういう関係値が構築できれば、AI技術を使っていく上では鬼に金棒です。

秋山氏:

最後に、会社や個人としてどこに問題設定するのかも大きな話ですよね。

坂本氏:

課題を発見して、それを解くべきかどうか最終的に判断するのは人間の意志ですからね。問題設定力は今後大きく関わってくると思います。

秋山氏:

坂本さんから見て、意思決定力、マネジメント力、問題設定力のうち、一番伸ばすべきはどれだと思いますか?

坂本氏:

マネジメント力は自分自身も伸ばしていきたいと思っています。今後は生産性が高まった世界になり、今よりも素早くプロダクトをリリースし、PDCAを回せるようになるはずです。その中で働く上では、一緒に働いていて楽しい、面白い、ワクワクできる感覚が重要ですし、ともに一つのものを目指していくような場を作れる人が求められるでしょう。

秋山氏:

ワクワク感は重要ですよね。私はどちらかというと意思決定力や問題設定力に興味があるのですが、それはやはり、問題設定自体がつまらないとワクワクしないからです。「何を解決するのか」はかなり考える必要がありそうです。

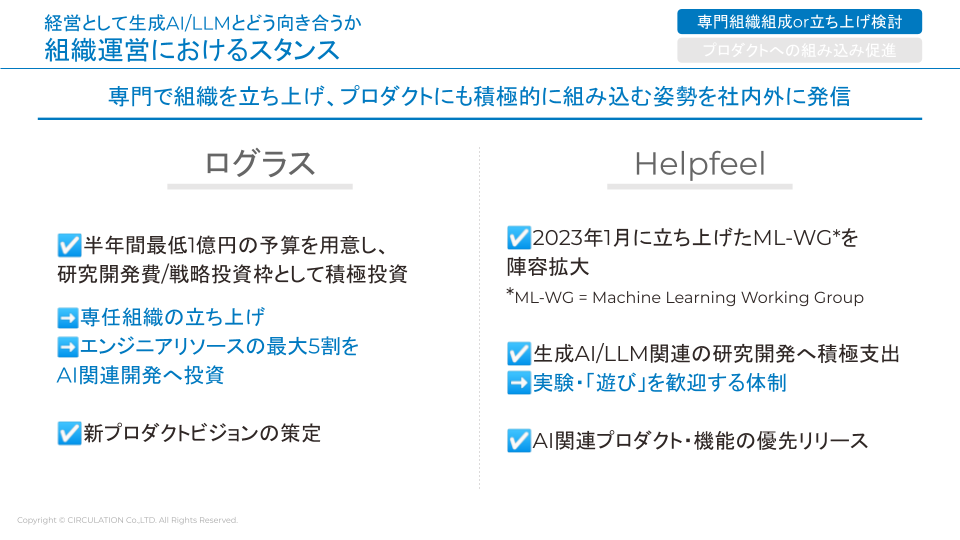

経営として生成AI/LLMとどう向き合うか

組織運営におけるスタンス:専門組織組成or立ち上げ検討

秋山氏:

経営の文脈でも、CTOとしてどのように生成AIやLLMと向き合うのかについて議論したいと思います。まずログラスさんとHelpfeelには、「専門組織組成or立ち上げ検討」と「プロダクトへの組み込み促進」、2つの共通する取り組みがありますね。

ログラスさんはすでに組織化を先行して実施されているそうですが、どのような取り組みなのかを簡単にお伺いしてもいいですか?

坂本氏:

まずは、半年間で最低1億円の予算を用意するという大きな決定をさせてもらいました。研究開発費や戦略投資の枠として、投資を続けていく決断ですね。また、私をマネージャーとした2名のメンバーで専任組織を立ち上げ、全エンジニアリソースの最大5割をAI関連開発に投資する方針も立てています。

また、新プロダクトビジョンを策定しました。「MAKE NEW DIRECTION」と題して、人間の処理できる規模を超えたデータを使いながら、データ間の関係性や背景コンテキストを考慮した経営判断をしていこうとしています。具体的には、どんな企業でも世界最高レベルの経営判断ができるような世界を目指し、データ収集や統合、分析の一歩先の意思決定そのものに価値を生み出していく取り組みです。

秋山氏:

ありがとうございます。当社の取り組みも簡単に紹介しますと、AIに一歩踏み込むために2023年1月時点でML-WG(Machine Learning Working Group)を組成しました。社内の担当者がマシンラーニングの活用を考えていたのですが、3月のChatGPT4の公開に衝撃を受けて、さらなる陣容拡大の準備を進めています。

あとは生成AIやLLM関係の研究開発への積極支出ですね。強制的にやらせるというよりは、実験や遊びをできるような体制を作っていきたいと考えています。当社にはボトムアップの文化があるので、楽しくアイデアを出してもらおうかなと。実際、今は社内でChatGPTを使ったbotが増えていたりしますし、そこから得られた知見を横展開していきたいですね。

AI関連のプロダクトや機能についても、優先的にリリースする予定です。

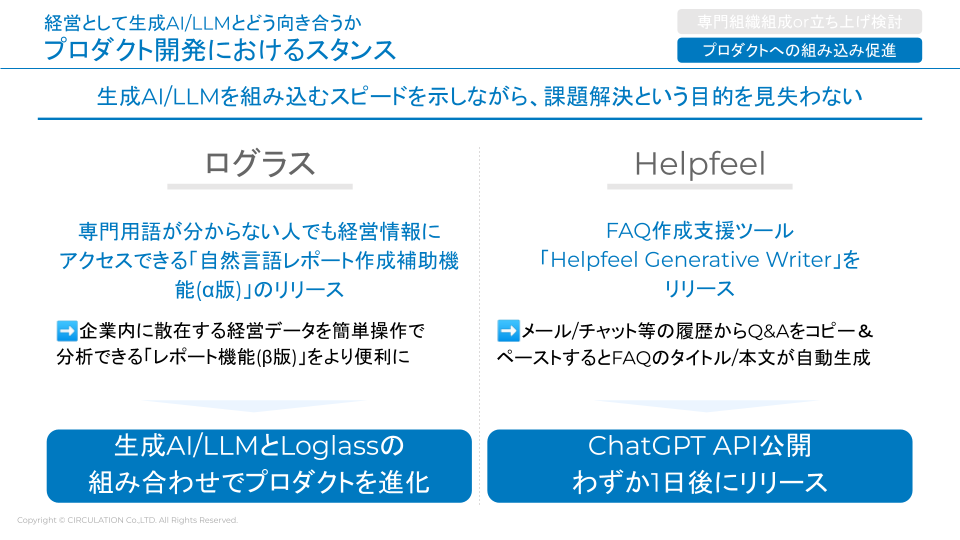

組織運営におけるスタンス:プロダクトへの組み込み促進

秋山氏:

プロダクトへの組み込み促進について、ログラスさんはいかがですか?

坂本氏:

我々は自然言語レポート作成補助機能のα版をリリースしています。弊社プロダクトには経営情報を見ていただくようなダッシュボードがあり、期間や切り口、見せ方を指定すればレポートを作成できるのですが、普段エクセルやスプレッドシートを触らない方にとっては難しい機能でした。そこで、日本語で指示することで自動的にレポートを作れるような機能として、自然言語レポート作成補助機能を作成したのです。

秋山氏:

「α版」なのは、どんなニュアンスなんですか?

坂本氏:

やはり「早めのトライ」を体現しようとした部分が大きいです。自分たちが大規模な投資をしていく意思表示としても、プロダクトを出すのは大いに価値があります。α版ではあるもののこれまでにはない機能ですし、お客様に使っていただいた上でどうだったのか話を聞く必要性も考え、一旦リリースをする決断をしました。

秋山氏:

当社の場合は、「Helpfeel Generative Writer」というツールをリリースしました。メールやチャットの履歴をコピーアンドペーストすると、FAQのタイトルと本文が自動生成されるものです。当社はFAQの検索エンジンを開発している会社ですが、FAQにChatGPTを載せるのではなく、FAQを書くためのツールを開発したわけです。

ChatGPTのAPIが公開されて、わずか1日後にリリースしたのは、ある種の自慢ポイントです(笑)。3月2日に衝撃が走り、会議をしながら作ってしまいました。使うのが簡単なので、4~5時間もあれば便利なものが作れてしまうんですよね。即日に出せる範囲で何が顧客にとって一番価値になるかを考え、SaaS事業者として「こう使うと便利ですよ」と提案していくのは、大きな意味があったと思います。

Q&A

ここからはイベント中に参加者からいただいた質問に回答していただきました。

期間内に課題解決できない場合に目標との擦り合わせはどうする?

Q.ChatGPTでは解けない大きな課題を解こうと思ったときに、OKR等で設定している期間内に終わらない可能性を大いに含んでいると思います。その際の目標との擦り合わせはどのようにしようとお考えですか?

坂本氏:

具体的には、「これを作る」という設定をしないようにしましたね。その上で期間を区切り、期待値の調整をしました。

本当は価値のある大きな機能をリリースする方向に行きたいのですが、そうするとPDCAが全く回らなくなってしまうんですよね。生成AIをお客様に使ってもらい、UXを改善するサイクルが今のチームでやるべきことですから、そのために期間を区切ったんです。

例えば、5月から1ヶ月間は、セールスやCSの業務課題をひたすら解決すると決めました。目の前の人の課題解決をしていくことで、生成AIの限界やリリース、デリバリーに関するノウハウが溜まっていきます。さらに6、7月については、勉強や情報収集をし続けるかたわら、プロダクトのリリースや現状のシステム自体を強化するような内容にフォーカスしていこうとしています。テーマ探しや技術・知見の蓄積をOKRにしてもらっている感じですね。

秋山氏:

ChatGPTで一発大きな機能を作ろうと思えば作れますが、プロダクトのアップデートがおざなりになるのは会社としてどうかということにもなりますしね。

当社は今まさに評価テーブルを作っている最中ですが、課題を解決したから評価されるというよりは、リリースしたもののデリバリーがきちんとできているかを見ていくと思います。

(番外編)当日取り上げられなかった質問と回答を一挙公開!

ChatGPTに入力する情報の取捨選択はどのように行うべきか?

Q.ChatGPTなどに機密情報を入力すると学習に使われるなどの懸念から入力する情報は取捨選択するべきであると個人的に思うのですが、お二方はどのようにお考えでしょうか?

坂本氏:

本領域は状況が目まぐるしく変わっているので、現時点での回答となりますが、履歴と学習を無効化することが出来るようになったので、私は常にオンにしています。

秋山氏:

ChatGPTとAPIそれぞれについて考える必要があると思います。

ChatGPTについては学習をオプトアウトできるため、オプトアウトして使うと良いと思います。オプトアウトした後については、GmailやSlackのような一般的なSaaSと同様に運営会社を信用できるかどうかという議論になるかと思いますが、OpenAI社がこれだけ注目を集める中で故意に送信された情報を悪用する可能性は十分に低いと考えています。

APIについてはリリース時点で学習に利用されないことが明記されていたため、送信しても問題ないかと思います。ただし、エンドユーザーに対してOpenAI社に送信することを明記した方がより親切だと思います。

生成AI/LLMの使い方等も評価に将来組み込むのか?

Q.これらGenerative AIやLLMに対する習熟度、つまりプロンプトの上手さ、みたいなものも評価制度的なところに組み込んだり検討したりしていますでしょうか?

坂本氏:

本領域は状況が目まぐるしく変わっているので、現時点での回答となります。

プロンプトの上手さが事業成長やお客様への価値提供の大きさに左右される能力であれば、評価制度に組み込むなどは良い手段かと思います。弊社では、現時点では、上記が直結しないため、そのような考え方はしておりません。

秋山氏:

当社でただちに「プロンプトの上手さ」を評価制度に組み込むことは無いかと思います。日々変化するこの領域と、半年〜1年スコープで評価する評価制度との相性があまりよくないと思うためです。

プロンプトの上手さを評価項目に加えることはありませんが、良いプロンプトを上手くプロダクトに組み込めた場合は、他の評価項目の加点要素として評価することになるかと思います。

まとめ

今回はChatGPTをはじめとした生成AI/LLMを積極的に活用しているログラス社、Helpfeel社の各CTOからエンジニアの働き方や必要スキルはどう変化するか、といった観点でお話をいただきましたが、いかがでしたか?

両社ともかなりのスピードでプロダクトへ組み込んだり、専任組織を立ち上げたりと今後益々AIと上手に向き合っていく必要がありそうです

利便性とリスク、双方しっかりと把握しながら日々の業務等で積極的に活用していきましょう。